فردای اقتصاد- هوش مصنوعی به سرعت در حال توسعه است و بیشترین چیزی که از توسعه آن میشنویم جایگزین شدن آن با مشاغل مختلف است. آیا باید مغزهای غیر انسانی را توسعه داد در حالی که ممکن است در آینده جایگزین مغزهای انسانی شوند؟ آیا باید ریسک از دست رفتن بشریت را در نظر گرفت؟ آیا از ترس هوش مصنوعی و جایگزین شدن شغلها باید به طور کل از حضور هوش مصنوعی در انجام کارها پرهیز کرد؟ این پرسشها ماه گذشته توسط نامه سرگشاده یک نهاد غیر انتفاعی به نام انستیتو آینده زندگی مطرح شد که در آن خواستار توقف شش ماهه در زمینه توسعه انواع پیشرفته هوش مصنوعی شده بودند. در میان امضاکنندگان این نامه نامهای مشهوری از حوزه تکنولوژی نیز به چشم میخورد از جمله ایلان ماسک.

این نامه نشانگر اوجگیری نگرانیهای عمیق از پتانسیلهای خطرآفرین رشد هوش مصنوعی است.به طور مشخص توسعه مدلهای زبانی بزرگ (LLM) در حوزه هوش مصنوعی که به ویژه در ربات چت جی پی تی (Chat GPT) مورد استفاده قرار گرفته باعث شگفتی بسیاری شده و حتی سازندگان آن در استارتاپ OpenAI را هم متحیر کرده است. این تواناییهای جدید شامل هرچیزی از حل معماهای منطقی تا نوشتن کدهای کامپیوتری، شناسایی نام فیلم از روی خلاصه داستان تا حتی تولید ایموجی میشود.

این مدلهای جدید میتوانند ارتباط انسان با کامپیوتر، دانش و حتی رابطه انسان با خودش را متحول کند. استدلال طرفداران هوش مصنوعی این است که به کمک این تکنولوژی میتوان داروهای جدید را توسعه داد، به طراحی مواد جدیدی اقدام کرد، با تغییرات آب و هوایی جدید مقابله کرد و پیچیدگیهای انرژی همجوشی هستهای را از بین برد. از نظر مخالفان هوش مصنوعی رشد سریع این تکنولوژی، خطرات کشنده سناریوی پیشی گرفتن ماشین از مخترع خود را گوشزد میکند.

این ترکیب جوشان هیجان و ترس ( از هوش مصنوعی ) سنجش فرصتها و خطرات این عرصه را دشوار میکند اما میتوان از سایر صنایع و حتی از تغییرات فناوری در گذشته درس آموخت. چه چیزی تغییر کرده است که هوش مصنوعی را توانمندتر از تکنولوژیهای دیگر کرده است؟ چقدر باید ترسید ودولتها چه باید بکنند؟

از تشخیص تصاویر تا چت جی پی تی

موج اول سیستمهای هوش مصنوعی مدرن، که یک دهه پیش پدیدار شد، روی دادههای آموزشی با برچسبگذاری دقیق تکیه داشت. پس از قرار گرفتن در معرض تعداد کافی نمونه برچسبگذاری شده، این سیستمها قادر به کارهایی مانند آموختن تشخیص تصاویر یا تبدیل گفتار به متن بودند.

سیستمهای امروزی نیازی به برچسبگذاری اولیه ندارند و در نتیجه میتوان با استفاده از مجموعه دادههای بسیار بزرگتری که از منابع آنلاین گرفته شدهاند، آنها را آموزش داد. مدلهای زبانی بزرگ (LLM) در واقع می تواند توسط کل محتوای اینترنت آموزش داده شود که این موضوع میتواند قابلیتهای خوب و بد آن را توضیح دهد.

زمانی که Chatgpt در نوامبر سال گذشته میلادی منتشر شد، این قابلیت ها برای عموم مردم آشکار شد. یک میلیون نفر در عرض یک هفته از آن استفاده کردند و این تعداد در طی دوماه به ۱۰۰ میلیون نفر رسید. به سرعت چت جی پی تی مورد استفاده عموم قرار گرفت و از آن برای تولید انشاهای مدرسه و حتی سخنرانیهای عروسی استفاده شد. محبوبیت چت جی پی تی و اقدام مایکروسافت در گنجاندن آن در موتور جست و جوی بینگ رقبا را هم به فکر انتشار محصولات مشابهی کرد.

در مورد چت جی پی تی بخوانید: پشت پرده ChatGPT چه میگذرد؟

برخی از این موارد نتایج عجیبی به همراه داشت. از جمله آنکه چت موتور جست و جوی بینگ به یک روزنامه نگار پیشنهاد کرد که همسرش را ترک کند یا در موردی دیگر یک استاد حقوق این چت را به ایراد افترا متهم کرد.

پاسخهایی که این سیستم ارایه میکند عموما دارای حقیقت هستند اما اغلب با اشتباهات واقعی یا جعل آشکار هم همراهند. با این حال مایکروسافت گوگل و سایر شرکتهای فناوری شروع به استفاده از سیستم LLM در محصولات خود کردهاند تا به کاربران در ایجاد اسناد و انجام کارهای مختلف کمک کنند.

آیا میتوان هوش مصنوعی را کنترل کرد؟

شتاب اخیر در قدرت و دید سیستمهای هوش مصنوعی و افزایش آگاهی از تواناییها و نقصهای آنها، این نگرانی را ایجاد کرده است که این فناوری اکنون به سرعت در حال پیشرفت است و نمیتوان آن را به طور ایمن کنترل کرد. از این رو فراخوانی برای توقف موقت توسعه آن منتشر شده که از به خطر افتادن کل بشریت ابراز نگرانی میکند.

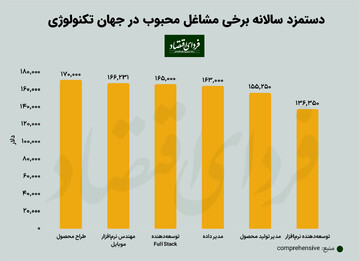

ترس از اینکه ماشینها مشاغل انسان را بدزدند قرنها سابقه دارد.تا پیش از این ماشینها عمدتا جایگزین نیروهای کار غیر ماهر شده بودند با این حال مدلهای جدید هوش مصنوعی حتی قادر به انجام کارهای پیچیدهتر مانند نوشتن کدهای کامپیوتری هم هستند.

در مورد درجه خطر هوش مصنوعی اختلاف نظرهای زیادی وجود دارد. در یک نظرسنجی از محققان هوش مصنوعی که در سال 2022 انجام شد، 48٪ معتقدند که حداقل 10٪ احتمال دارد که تاثیر هوش مصنوعی منجر به اتفاقات "بسیار بد مثلاً انقراض انسان رخ دهد. اما ۲۵ درصد خطر ان را صفر تلقی میکنند.

کابوس این است که یک سیستم هوش مصنوعی پیشرفته با ساختن سم یا ویروس یا ترغیب انسان به انجام اقدامات تروریستی باعث آسیب در مقیاس گسترهتر شود. در واقع محققان نگرانند که اهداف آینده هوش مصنوعی ممکن است با اهداف خالقان انسانی آن همسو نباشد.

چنین سناریوهایی را نباید نادیده گرفت. اما همه اینها شامل مقدار زیادی حدس و گمان و جهشی از فناوریهای امروزی است. و بسیاری تصور می کنند که هوش مصنوعی در آینده دسترسی نامحدودی به انرژی، پول و قدرت محاسباتی خواهد داشت. برخی دیگر هم مانند ایلان ماسک که خود در حال راهاندازی شرکت هوش مصنوعی است ممکن است به دنبال توقف رقبا برای رسیدن کسب و کارشان به درجه بلوغ آنها باشد.

به نظر میرسد مقررات برای هوش مصنوعی لازم است اما دلایل نیاز به این مقررات پیش پا افتادهتر تر از نجات بشریت است. سیستم های هوش مصنوعی جدید نگرانیهای واقعی را درباره تعصب نژادی، حریم خصوصی و حقوق مالکیت معنوی ایجاد میکند. با پیشرفت فناوری مشکلات دیگری نیز ممکن است آشکار شوند.

رویکرد دولتها در برابر هوش مصنوعی

تاکنون دولت ها سه رویکرد متفاوت را در زمینه هوش مصنوعی در پیش گرفته اند. در یک انتهای این طیف بریتانیا قرار دارد که رویکرد "لمس سبک" را بدون ایجاد قوانین یا نهادهای نظارتی جدید پیشنهاد کرده است، اما مقررات موجود را برای سیستمهای هوش مصنوعی اعمال میکند. هدف این کشور افزایش سرمایه گذاری و تبدیل بریتانیا به یک "ابرقدرت هوش مصنوعی" است. آمریکا رویکرد مشابهی را در پیش گرفته است، اگرچه دولت بایدن اکنون به دنبال نظر افکار عمومی است و ممکن است در آینده این به کتابچهای از قوانین در زمینه هوش مصنوعی تبدیل شود.

اتحادیه اروپا موضع سختتری را در پیش گرفته است. قانون پیشنهادی این اتحادیه، استفادههای مختلف از هوش مصنوعی را بر اساس درجه خطر طبقهبندی میکند، برخی از کاربردهای هوش مصنوعی در این اتحادیه کاملا ممنوع هستند و شرکتهایی که قوانین را زیر پا بگذارند جریمه خواهند شد. از نظر برخی منتقدان این قوانین بسیار سختگیرانهاند.

اما برخی دیگر می گویند رویکرد سخت گیرانه تری لازم است. دولتها باید مانند داروها باید اقسام هوش مصنوعی را به صورت دقیق مورد آزمایش قرار دهند. چین برخی از این کارها را انجام میدهد و شرکتها را ملزم کرده تا محصولات مصنوعی را ثبت کنند و قبل از عرضه، بازبینی امنیتی روی آنها انجام میگیرد.

در همین زمینه بخوانید: روایت اکونومیست از جنگ ChatGPT و گوگل

چه باید کرد؟

بعید است که رویکرد لمسی سبک ( آنچنانکه بریتانیا به دنبال آن است) کافی باشد. اگر هوش مصنوعی به اندازه ماشینها، هواپیماها و داروها یک فناوری مهم باشد - و دلیل خوبی برای این باور وجود دارد - پس مانند آنها به قوانین جدیدی نیاز دارد. بر این اساس، مدل اتحادیه اروپا نزدیکترین مدل به علامت است، اگرچه سیستم طبقهبندی آن بیش از حد پیچیده است.

اما میتوان در صورت نیاز مقررات سختگیرانهتری را در طول زمان فراهم کرد. ممکن است یک رگولاتوری اختصاصی برای هوش مصنوعی مناسب به نظر برسد. همچنین ممکن است در صورتی که شواهد قابل قبولی مبنی بر وجود خطر جدی دیده شود معاهدات بین دولتی مشابه پیمانهایی که بر تسلیحات هستهای مورد توافق قرار گرفته هم مطرح شود. برای نظارت بر این خطر دولتها میتوانند بدنهای را با الگوبرداری از CERN ( سازمان اروپایی پژوهش هستهای )تشکیل دهند. یک آزمایشگاه بزرگ که میتواند ایمنی و اخلاقیات در حوزه هوش مصنوعی را مورد مطالعه قرار دهد. حوزههایی که شرکتها انگیزهای برای سرمایهگذاری در آن ندارند.

برای نظارت بر این خطر، دولتها میتوانند بدنهای را با الگوبرداری از cern تشکیل دهند، یک آزمایشگاه فیزیک ذرات، که همچنین میتواند ایمنی و اخلاقیات را مورد مطالعه قرار دهد - حوزههایی که شرکتها انگیزهای برای سرمایهگذاری به اندازه جامعه ندارند.

این فناوری قدرتمند خطرات جدیدی را ایجاد می کند، اما فرصت های خارق العاده ای را نیز ارائه می دهد. متعادل کردن این دو به معنای گام برداشتن با دقت است. یک رویکرد سنجیده امروزی میتواند پایههایی را فراهم کرد که پایهگذار قوانین بیشتری در آینده باشد. اکنون زمان ساخت این پایههاست.

تبادل نظر